来源:机器之心

作者:Eric Jang

机器之心编译

编辑:魔王、张倩

在这篇文章中,谷歌 Robotics 研究科学家 Eric Jang 对生物学可信深度学习(BPDL)研究提出了质疑。他认为,设计反向传播的生物学可信替代方法压根就是一个错误的问题。机器学习领域的一个严重错误就是,对统计学工具和最优控制算法赋予了太多生物学意义。

生物学可信深度学习 (BPDL) 是神经科学与机器学习交叉领域中的一个活跃研究课题,主要研究如何利用在大脑中可实现的「学习规则」来训练深度神经网络。

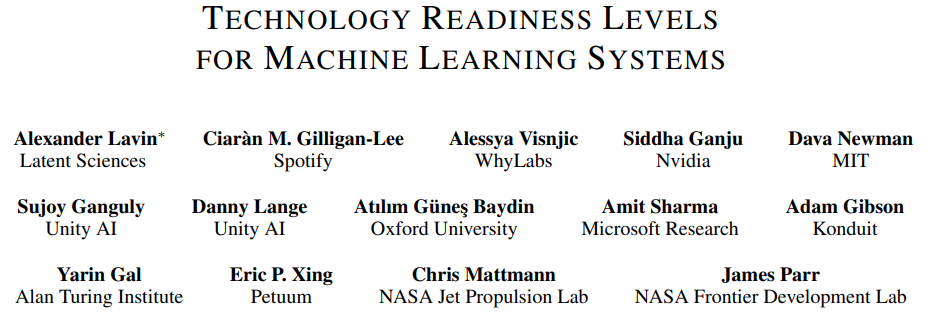

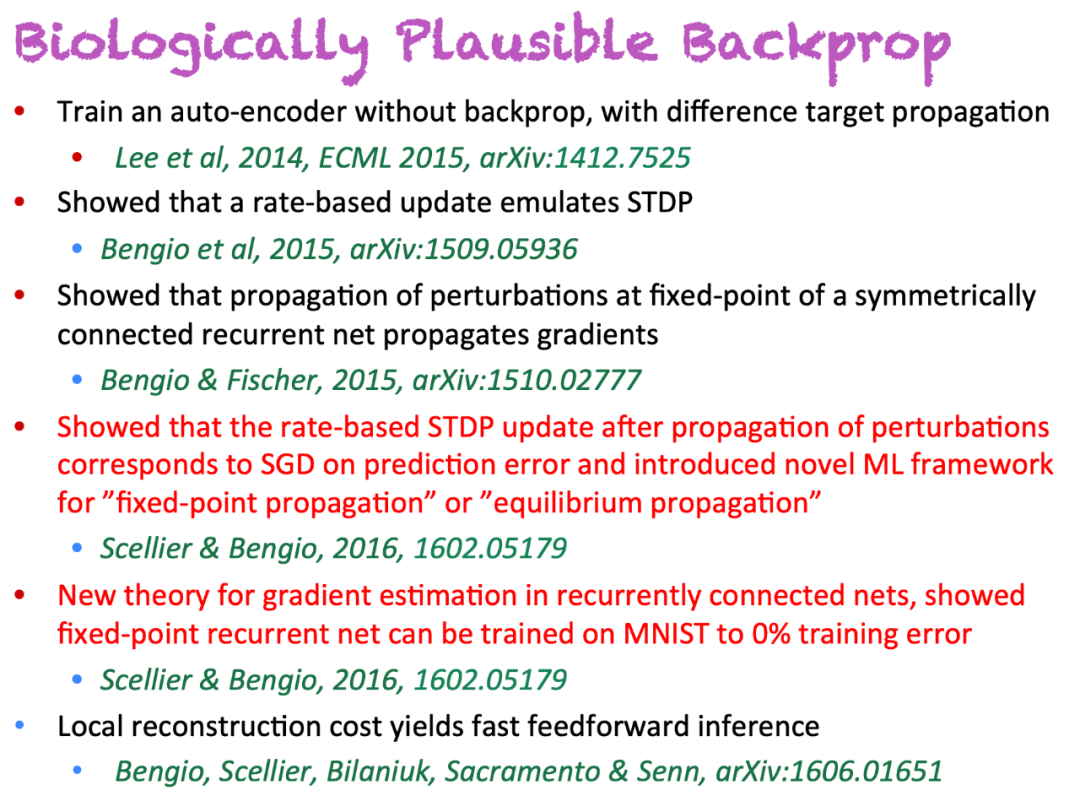

2015 年,深度学习巨头 Yoshua Bengio 发表论文《Towards Biologically Plausible Deep Learning》,探索了更加符合生物学逻辑的深度表征学习版本。该论文的主要观点如下:

负责突触权重更新的基础学习规则 (Spike-Timing-Dependent Plasticity, STDP) 源于一个简单的更新规则,该规则从机器学习的角度来看是有意义的,可以理解为在某个目标函数上的梯度下降,只要神经动态活动能将放电速率推向更好的目标函数值(可能是监督式、无监督式或奖赏驱动的);

这与变分 EM 法的形式相对应,也就是使用神经动力学实现的近似而非精确的后验;

我们可以利用近似来估计上述变分解释(variational interpretation)中更新隐藏状态所需的梯度,只需将激活向前和向后传播,并且用成对的层来学习形成去噪自编码器。

次年,在 NIPS 2016 Workshop 上,Yoshua Bengio 做了同名演讲,其中就探讨了「反向传播」机制的生物学可信性。

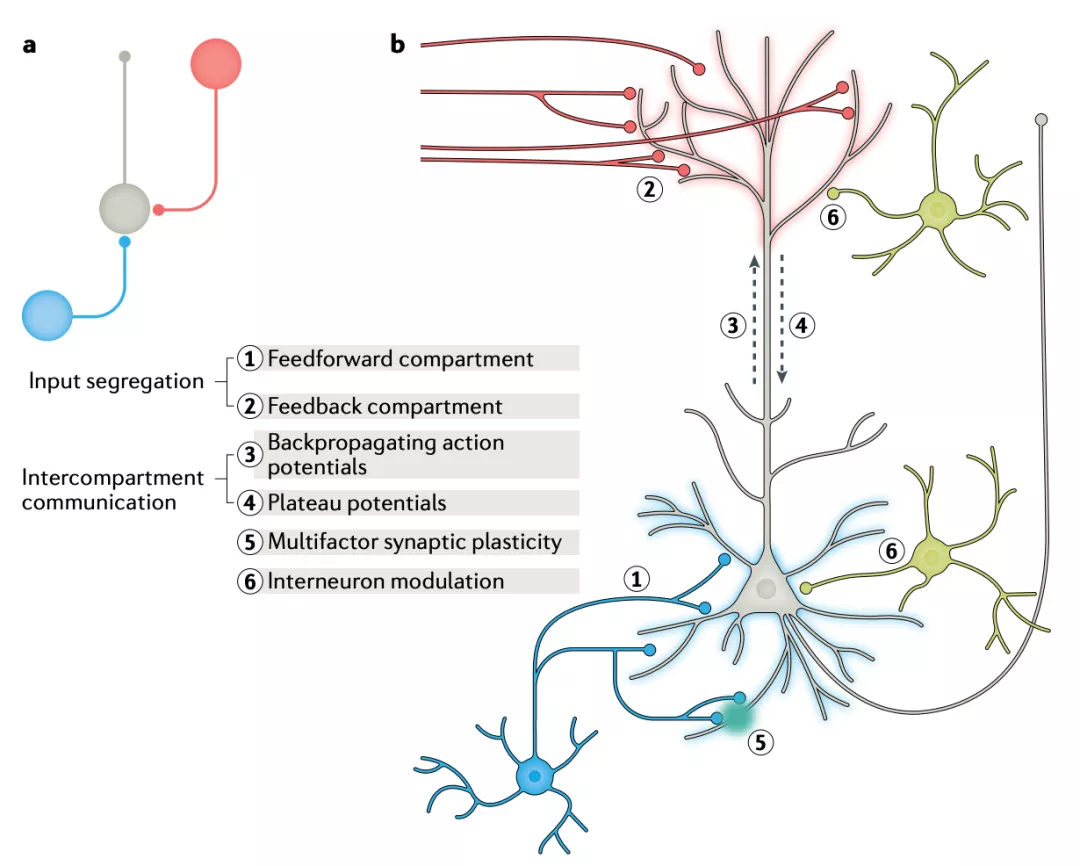

在学习过程中,大脑会调整突触以优化行为。在皮层中,突触嵌入在多层网络中,这导致我们难以确定单个突触的调整对整个系统行为的影响。而反向传播算法在深度神经网络中解决了上述问题,不过长期以来人们一直认为反向传播在生物层面上存在问题。

去年 4 月,来自 DeepMind、牛津大学和谷歌大脑的 Timothy P. Lillicrap、Adam Santoro、Geoffrey Hinton 等人在 Nature 子刊《Nature Reviews Neuroscience》发表文章,认为反向连接可能会引发神经活动,而其中的差异可用于局部逼近误差信号,从而促进大脑深层网络中的有效学习。即尽管大脑可能未实现字面形式的反向传播,但是反向传播的部分特征与理解大脑中的学习具备很强的关联性。

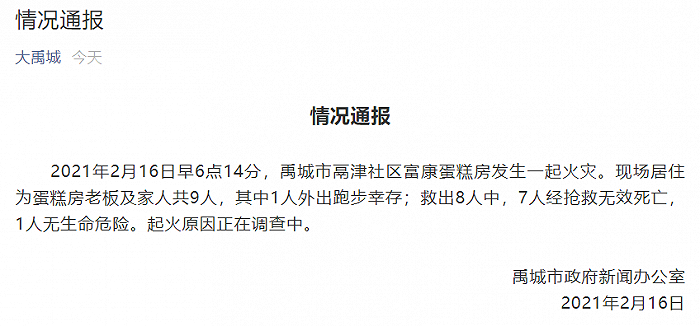

大脑对反向传播算法的近似。

然而,讨论并未终止。最近,谷歌 Robotics 研究科学家 Eric Jang 发表博客,对 BPDL 中的反向传播观点提出质疑。

反向传播为什么一定要有生物学对应?

Eric Jang 首先列举了推动 BPDL 发展的主要原因:

深度神经网络 (DNN) 可以学习执行生物大脑能够完成的感知任务(如目标检测与识别);

如果激活单元及其权重与 DNN 的关系相当于神经元和突触之于生物大脑,那么反向传播(训练深度神经网络的主要方法)与什么类似呢?

如果使用反向传播无法实现大脑中的学习规则,那么这些规则要如何实现呢?基于反向传播的更新规则如何在遵循生物学约束的同时实现类似的性能?

有人曾列举了反向传播并非生物学可信的诸多理由,以及提出修复办法的多种算法。

来源:https://psychology.stackexchange.com/questions/16269/is-back-prop-biologically-plausible

而 Eric Jang 的反对意见主要在于,设计反向传播的生物学可信替代方法压根就是一个错误的问题。BPDL 的重要前提中包含了一个错误的假设:层激活是神经元,权重是突触,因此借助反向传播的学习必须在生物学习中有对应的部分。

尽管 DNN 叫做深度「神经网络」,并在多项任务中展现出了卓越能力,但它们本质上与生物神经网络毫无关联。机器学习领域的一个严重错误就是,对统计学工具和最优控制算法赋予了太多生物学意义。这往往使初学者感到困惑。

DNN 是一系列线性操作和非线性操作的交织,序列应用于实值输入,仅此而已。它们通过梯度下降进行优化,利用一种叫做「反向传播」的动态规划机制对梯度进行高效计算。

动态规划是世界第九大奇迹,Eric Jang 认为这是计算机科学领域 Top 3 成就之一。反向传播在网络深度方面具备线性时间复杂度,因而从计算成本的角度来看,它很难被打败。许多 BPDL 算法往往不如反向传播,因为它们尝试在更新机制中利用高效的优化机制,且具备额外的约束。

如果目标是构建生物学可信的学习机制,那么 DNN 中的单元不应与生物神经元一一对应。尝试使用生物神经元模型模仿 DNN 是落后的,就像用人脑模拟 Windows 操作系统一样。这很难,而且人脑无法很好地模拟 Windows 系统。

我们反过来试一下呢:优化函数逼近器,以实现生物学可信的学习规则。这种方式较为直接:

使用模型神经元和突触连接构建神经网络的生物学可信模型。神经元利用脉冲序列、频率编码或梯度实现互相通信,并遵循任何「生物学可信」的约束。其参数需要训练。

使用计算机辅助搜索,为这些模型神经元设计生物学可信的学习规则。例如,将每个神经元的前向行为和局部更新规则建模为基于人工神经网络的决策。

更新函数逼近器,使生物学模型生成期望的学习行为。我们可以通过反向传播训练神经网络。

用来寻找学习规则的函数逼近器的选择是无关紧要的——我们真正在乎的是生物大脑如何学习像感知这样的困难任务,同时遵循已知的限制条件,如生物神经元不把所有的激活都存储在记忆中,或者只使用局部的学习规则。我们应该利用深度学习的能力找出优秀的函数逼近器,并以此来寻找优秀的生物学习规则。

「元学习」是另一种选择?

「我们应该(人工地)学习如何以生物的方式学习」并非一个全新的观点,但对于神经科学 + AI 社区来说,这一点还不够明显。元学习(学习如何学习)是近年来兴起的一个领域,它给出了获取能够执行学习行为的系统的方法,该系统有超越梯度下降的潜力。如果元学习可以帮我们找到更加样本高效或者更优秀、更鲁棒的学习器,那它为什么不能帮我们找到遵循生物学习约束的规则呢?其实,最近的几项研究 [1, 2, 3, 4, 5] 已经探索了这一问题。你确实可以使用反向传播来训练一个优于普通反向传播的独立学习规则。

Eric Jang 认为,很多研究者之所以还没理解这个观点(即我们应该用元学习方法来模拟生物学可信的回路),是因为目前算力还不够强,无法同时训练元学习器和学习器。要想制定元优化方案,我们还需要强大的算力和研究基础设施,但 JAX 等工具的出现已经让这一任务变得简单得多。

真正的生物学纯粹主义者可能会说,利用梯度下降和反向传播寻找学习规则不是一种「进化上可信的学习规则」,因为进化明显缺乏执行动态规划甚至是梯度计算的能力。但如果使元学习器在进化上可信,这一点就能得到修正。例如,用来选择优秀函数逼近器的机制其实根本不需要依赖反向传播。相反,我们可以制定一个元 - 元问题,让选择过程本身遵守进化选择的规则,但是选择过程还是使用反向传播。

所以,不要再给反向传播赋予生物学意义了!

原文链接:https://blog.evjang.com/2021/02/backprop.html

百万级文献分析,十万字深入解读

2020-2021 全球AI技术发展趋势报告

报告内容涵盖人工智能顶会趋势分析、整体技术趋势发展结论、六大细分领域(自然语言处理、计算机视觉、机器人与自动化技术、机器学习、智能基础设施、数据智能技术、前沿智能技术)技术发展趋势数据与问卷结论详解,最后附有六大技术领域5年突破事件、Synced Indicator 完整数据。