原标题:DataPipeline实时数据融合平台V3.0里程碑版发布!澎湃新动能

5月27日,DataPipeline新品发布会在上海成功举行。大会以“万「向」更新”为主题,重磅推出DataPipeline企业级实时数据融合平台V3.0里程碑版本。本次活动汇聚了全国近百位领域专家、行业学者、合作伙伴、媒体和分析师现场参会,分享对行业趋势的洞察、行业场景中的解决方案实践与探索,以“实时数据管理”激发产业创新澎湃新动能。

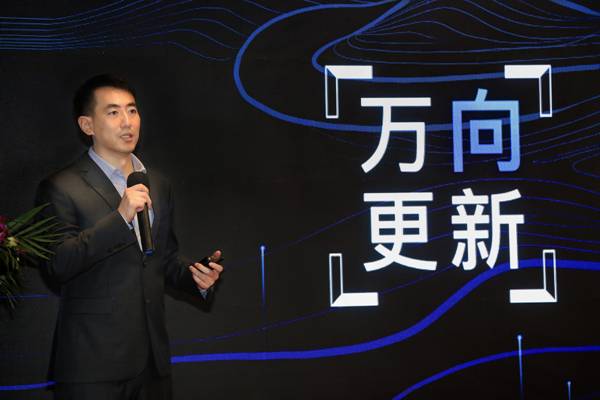

当前,随着技术的推动以及市场格局的快速变化,实时、精确地感知和洞察业务需求变得越发重要,实时数据管理已经成为加速企业发展的新引擎。发布会现场,DataPipeline创始人&CEO陈诚表示:“DataPipeline作为实时数据管理领域最早批布局者,始终以‘稳健的产品表现、引领性的技术实力、体系化的用户服务’为追求,致力于成为企业数字化转型过程中的优质和信任之选。”

01万「向」更新

DataPipeline:连接一切数据、应用和设备

DataPipeline创始人&CEO陈诚在致辞中对主题“万「向」更新”中的「向」字进行了层层递进的价值解读——阐释了由“发展方向、数据流向、创业者志向”构成的三阶理论,凸显DataPipeline做深、做广实时数据管理领域的意志和信心。

第一,发展方「向」。过去40年,中国经济发展取得的成就有目共睹,数据表示2020年中国世界五百强企业的数量已经超过美国,但盈利能力弱于后者。主要原因是美国企业在产业链布局更偏上游,也拥有更多“卡脖子”的技术。中国企业有待进一步利用数据资产及数字化技术,突破重围,从而谋求管理方式升级、流程再造、文化改变等更大的发展。

第二,数据流「向」。在企业发展的过程中,数据赋能智慧营销、客户服务、风险控制和经营分析管理已成为共识。因此,各种底层技术——存储和计算引擎、数据中台、数据湖、大数据平台、时序数据库、图数据库应运而生。数据流动性管理成为新挑战:越来越异构的引擎,越来越快的时效性要求,越来越复杂的数据链路,越来越高的数据质量标准。未来,谁能灵活掌控数据的流动性,谁就能在不断的技术进步中收获更大的价值。

第三,创业者志「向」。过去的20年,中国的消费互联网企业从模仿到创新,通过广阔的市场和资本加持的方式,成长出了世界级的产品和公司。现在,时代洪流把企业级软件领域推向制高点。在政策推动、产业升级和数字化转型的趋势下,行业中一定会诞生同样伟大的企业服务公司。DataPipeline的使命是“连接一切数据应用和设备”,立志成为中国的世界级数据中间件厂商。公司坚持技术驱动,深耕企业服务,帮助用户实现超越期待的企业级全域实时数据的价值释放。

02五年蓄力

DataPipeline实时数据融合平台V3.0重磅发布

DataPipeline合伙人&CPO陈雷在演讲中表示:

“移动互联网的兴起推动大数据平台建设只用了不到十年,对于金融行业甚至不到五年。金融、制造、零售、能源、地产等行业,大量客户都在从数字化转型向数字化创新迈进,作为企业数字化创新基础设施的数据管理技术也在不断进化,实时数据管理就在眼前。

实时风险控制、实时智能营销、实时运营管理等越来越多的业务场景和业务驱动力对数据提出了‘更快、更准、更全’的要求。对于实时数据管理,我们要把它提高到和数据仓库、数据湖甚至交易系统相同的重视程度和高度去建设,但其体系建设过程不是一蹴而就的,实时数据平台建设是该过程的关键基石。”

会上,陈雷对DataPipeline企业级实时数据融合平台V3.0这一里程碑版本的三大核心特性进行了重点介绍:

对主流关系型数据库、大数据平台及国产数据库支持的持续投入

采用基于日志的增量数据获取技术(Log-based change data capture),为主数据管理、数据仓库、大数据平台提供实时、准确的数据变化,从而使得客户可以根据最新数据进行运营管理与决策制定。

配置式链路定义无代码任务构建提升实时数据敏捷性

在数据节点、数据链路、融合任务及系统资源四个基本逻辑概念中,用户只需要通过二至三项简单配置就可以定义出可以执行的融合任务,系统提供基于最佳实践的默认选项,实时数据需求的研发交付时间从2周减少为5分钟。同时,为应对复杂的实时数据运行时场景需求,系统提供限制配置与策略配置两大类十余种高级配置。用户可以通过这些配置对下游概念进行限制与管理,亦可以通过这些配置来统一调整下游概念的执行范围与策略应用范围。

分布式引擎、组件级高可用保障实时链路稳定高容错

平台所有组件均支持高可用,容器化部署,平滑、灵活的动态扩缩容,允许将不同的计算任务重分布到不同的机器上去,而不妨碍其它部分的运行。从工具向平台的演化势必关系到可用性、业务连续性要求的不断提高,除了通过分布式引擎保障整个系统的可用性和数据完整性以外,产品也针对同城、异地灾备环境,数据容灾和应用容灾的不同要求给出切实可行的方案。

面对未来的不确定性,DataPipeline要构建确定的能力信仰:打破技术壁垒,让客户专注数据价值释放。后续,DataPipeline整体产品路线大概分为两个层面六个部分,即着重夯实:持续增强多元异构、不懈追求极致性能、升级企业级管理性,持续探索:平台全面云化探索、实时数据计算探索、实时数据治理探索。以上,皆旨在构建起业内最完善的实时数据管理产品矩阵,形成全链路实时数据资产管理业务体系。

03平滑演进

DataPipeline实时数据融合 “进化史”

回望成长之路,DataPipeline作为一家企业级批流一体数据融合产品、解决方案及服务提供商,公司的技术随着用户需求驱动、应用场景锤炼,不断创新。DataPipeline CTO陈肃表示:DataPipeline在发展过程中遵循的基本准则之一是追求技术演进的平滑性。我们坚信一个朴素的真理——做企业级的软件,不仅要知其然,而且要知其所以然,即对产品所有采用的基础架构底层原理和代码非常了解并可以迅速帮客户定位解决问题。

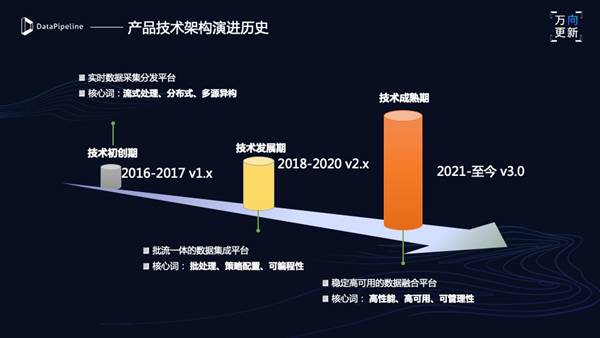

DataPipeline技术演进之路主要分为以下三个阶段:

▶DataPipeline1.0实时数据采集分发平台

核心词:流式处理、分布式、多源异构

在公司成立伊始,我们就认识到实时的流式处理代表了企业数据处理的未来,DataPipeline打造基于面向流式数据采集分发场景这样的产品,流式成为我们刚开始定义产品应用边界的关键核心要素;实现分布式的处理平台,支持多节点部署,从而能够根据业务需要动态扩展处理能力;支持各种异构存储之间的数据同步,当上游结构发生变化时,下游能够根据用户设置的策略进行应对,从而保证数据的完整性和任务的持续运行。

▶DataPipeline 2.0批流一体的数据集成平台

核心词:批处理、策略配置、可编程性

DataPipeline对底层的框架做了扩展,通过引入批次控制消息实现了流处理框架下的批流一体处理,扩展了我们整个产品可服务场景的边界;将核心处理逻辑的控制参数进行了全面的可配置化,用户可以通过DataPipeline提供的配置模板分别定义每个任务的处理逻辑、参数调优,满足特定场景下的性能优化需求;引入了基于WebIDE完成的高级编程功能,用户可以完成复杂的数据清洗、转换和统计逻辑,并与外部系统进行对接,一站式完成代码编写、试运行、下发,为用户提供了极大的处理便捷性;推出了源端和目标端连接器的开发者套件,基于此用户和合作伙伴可以迅速为特定场景开发出包含定制化处理逻辑连接器。

基于以上,DataPipeline从单一的数据采集分发平台进化为批流一体的数据集成平台。

▶ DataPipeline 3.0稳定高可用的数据融合平台

核心词:高性能、高可用、可管理性

DataPipeline运行着数以百计的任务,3.0版本引入了基于内存的数据交换方式,可以有效避免消息分区数量的膨胀带来的性能下降,基于这一模式的端到端处理速度,比2.0版本提升超过1倍;进一步将DataPipeline的所有平台组件全面实现了高可用,用户可以根据对可用性的要求,灵活进行组件节点的部署,避免单点故障;根据企业分层管理的需求,将系统内资源抽象为节点、链路、任务,每一层都可以进行独立的管理和授权。用户可以在链路上定义字段类型映射、限速、告警等策略,并应用到任务层面,从而实现层级化的精细管理。与此同时,DataPipeline内部的所有重要事件、告警信息都能够推送到用户定义的邮箱、文件路径或Webhook中,从而与企业既有的运维监控体系无缝集成。

至此,到3.0里程碑版本,DataPipeline构建起较为完整的企业级数据融合平台。

04实践&洞察

金融行业数据管理应用典范

发布会现场,来自西安交通大学、财通证券、民生银行的行业专家和客户代表还带来了各自关于金融行业数据管理应用的洞察与实践分享,从技术模式、规模化应用等维度为企业实时数据管理提供了创新型启示和参考。

西安交通大学电信学部客座教授刘铁博士讲到:

“人工智能的创新融合正为金融场景打造出一个兼具决策分析与感官感知的‘智慧大脑‘,首要一点,实时数据对金融行业是重要的生产力要素,数据要素流通和价值变现至关重要。实时数据加可靠算法可以帮助企业构建金融科技的创新智能底座。”

财通证券数据平台技术专家郑林峰表示:

“目前财通证券数据交换平台实现了公司含核心系统在内50+业务系统的数据交换,技术团队核心目标是利用流程、结构、技术的力量,建设一个符合金融行业数据流转稳定要求、操作简单、运维压力低、自定义能力强且对业务系统与业务人员更友好的系统。针对该目标,财通证券进行了四个关键点的划分,这与DataPipeline企业级实时数据融合平台产品理念具有有高度重合性:分布式架构、多元异构、高度开放性、批流一体,所以双方至今合作三年之久。”

民生银行总行科技大数据管理部技术专家钟行表示:

“2016年开始,民生银行科技部大数据开发团队开始为部分业务部门提供实时数据加工支持,基于客户的交易信息提取出各类实时事件,得益于时效性提升带来的良好体验,行内业务部门不断提出更复杂的实时数据加工需求,新需求的加工复杂度持续升高、使用场景持续扩展、交付效率持续加快、运营质量要求持续提升。为提升实时数据支撑能力,民生银行开始从‘平台、数据、应用’三个方面进行实时数据体系建设。通过对DataPipeline的调研和产品验证,其产品在异构传输功能的丰富性、后续扩展性、运营保障能力等方面满足作为平台实时数据传输组件的要求,双方从2020年1月正式展开合作,克服了疫情带来的影响,目前已完成一期项目大部分工作实施。”

人之有能有为,使羞其行,而邦其昌。

时代在变,需求在变,数字化的含义在变,但在DataPipeline成长的道路上,价值的重要性不变,坚持“以客户为中心,以技术驱动”为第一出发点不变。

上周,DataPipeline宣布完成B轮数千万人民币融资。陈诚在发布会中谈到:“不积跬步无以至千里。在DataPipeline发展过程中,感谢客户的信任、包容和对我们的要求,客户是我们前进的动力,也是我们灵感的来源,我们会持续以最大的资源和能量投入到对产品的研发和客户服务中,来帮助我客户管理好数据的流动性。”

未来,DataPipeline将在这一赛道上持续深耕,加速推动实时数据管理产品与方案在各行各业全面落地生花,加速企业业务创新和转型升级。