原标题:国家新一代AI治理专委会委员:将伦理与治理嵌入AI全生命周期

“如果从人工智能发展的瓶颈和现状看,我们可以说现在的人工智能并不可信。”

中国科学院自动化研究所研究员、国家新一代人工智能治理专委会委员、联合国教科文组织人工智能伦理特设专家组专家曾毅在近日举行的首届全球数字经济大会人工智能产业治理主题论坛上作出以上表述。

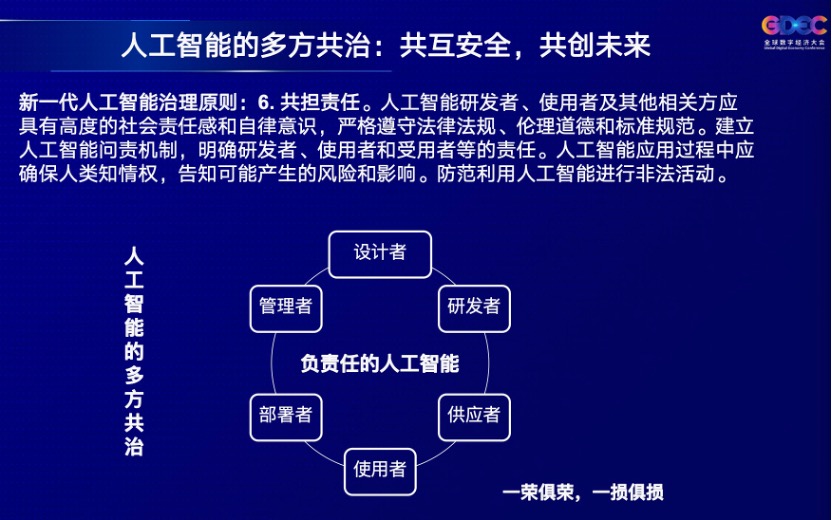

曾毅的主题演讲题目为《负责任的人工智能:可持续发展与治理的深度协同》。他认为,政策的良性引导已经开始了,但所有的设想的技术落地却困难重重。禁用特定的技术是不解决问题的,应当将伦理与治理嵌入人工智能产品的全生命周期,并形成政府、学术界、企业、公民社会、媒体、用户、服务提供商等多方主动共治的良性生态。

作为引领第四次科技革命的战略性技术,人工智能给社会建设和经济发展带来了重大而深远的影响。不过人工智能的治理问题也愈发重要。虽然人工智能在纯技术层面是价值中立的,但在实际应用中,兼具创造性和破坏性。数据隐私、算法偏见、技术滥用等安全问题正给社会公共治理与产业智能化转型带来严峻挑战。

人脸识别滥用、数据隐私侵犯等人工智能伦理问题在近年逐步受到法律规范。就在近期,7月28日,最高人民法院召开新闻发布会,发布《最高人民法院关于审理使用人脸识别技术处理个人信息相关民事案件适用法律若干问题的规定》,对滥用人脸识别问题作出司法统一规定。国际上,2018年出台的欧盟的通用数据保护条例以严厉执行著称,也正在施行中。

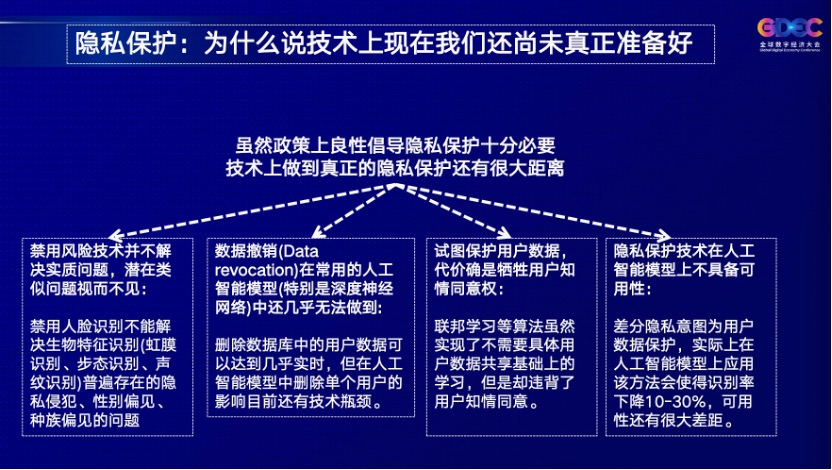

曾毅提出一个问题,为什么西方社会人脸识别被禁用,但是企业没有很大反对声音?“一个不争的事实是,企业可以找到替代方案,”曾毅进一步阐述,当人脸识别被禁用时,固态识别、指纹识别、声纹识别被使用,其风险与人脸识别相同,但因为这些方法没有进入公众视野,所以没有引起公众的关注。

此前《华盛顿邮报》也有报道,有攻击者假冒公司CEO利用音频版深度伪造技术制造了一段虚假语音,最终成功敲诈一家英国能源公司24万美元。被敲诈公司的保险公司 Euler Hermes的一位女发言人曾说:“该软件能够模仿声音,包括音调、标点符号和德国口音。”

曾毅认为,人脸识别技术的禁用并不代表问题被彻底解决。人脸识别存在的风险,如对隐私的泄露、对公平性的侵犯、技术的不成熟性导致种族和性别之间的歧视等,在任何一个生物特征识别的方法中都存在。

包括欧盟通用数据保护条例中用户的被遗忘权(数据主体有权要求数据控制者删除与其相关的个人数据,数据控制者有义务删除数据主体的个人数据,并不得无故拖延),用户可以要求企业从数据库中删除自己的数据。但曾毅表示,“如何在人工智能的模型和服务中删除用户的数据和特征,这个在技术上实际存在极大困难,几乎没有人可以做到在一个深度学习模型中删除单个用户对这个结果的影响。而如果重新训练人工智能模型,一些大模型训练一次就需要五百万,于是在更多时候,选择不去更新就是现状。”

当下存在保护用户数据的一些方法,但是其代价是牺牲其他的方面。曾毅以联邦学习举例,其可以在不分享自己数据的情况下在数据模型上进行联合学习。这样保护了用户隐私数据,但也回避了一个问题——用户的知情同意,用户有没有同意把数据以数据模型的形式共享给其他的企业和应用?

也比如差分隐私(差分隐私模型中,攻击者的计算能力及其所获取的辅助信息不会影响隐私保护程度),曾毅认为这在数据库时代效果很好,但引入人工智能模型以后,会使人工智能的识别率下降10%到30%。那么对企业来说,为了保护隐私而使识别率下降10%到30%,这可能也是非常困难的选择。

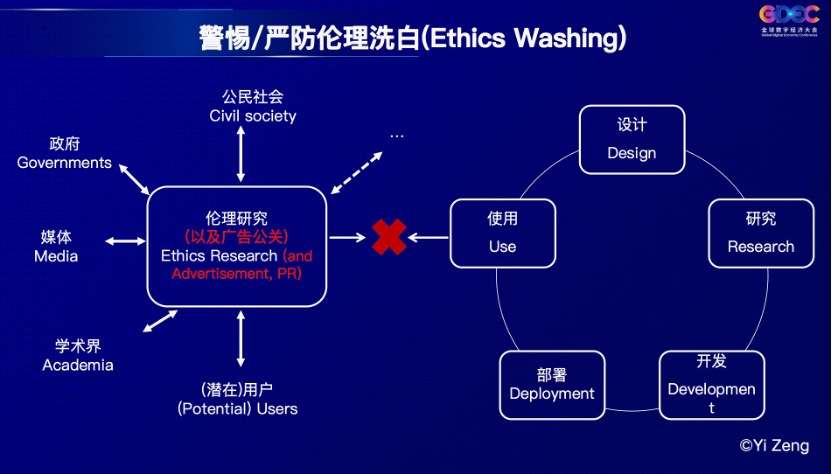

“人工智能企业是谈伦理最多的公司,但出伦理的问题也最多,大公司虽然有自己的伦理研究团队,但很难将伦理研究的成果应用到设计、研发、部署这些步骤中,有时候仅仅起一个伦理洗白的作用,”曾毅认为。

由此,曾毅呼吁,企业应该成为人工智能治理的重要参与者,但不只有企业。设计者、研发者、供应者、部署者、管理者等都需要承担自己的责任,真正实现敏捷治理和多方的共治。近期,北京智源人工智能研究院和中科院自动化所共同研发了人工智能治理公共的服务平台,把人工智能从监管变成公共服务,向企业和研发机构特别是没有能力开展企业合规、伦理委员会的建设,治理委员会建设这样的企业,去进行公开、免费的服务。

曾毅现场提出了一个解决方案,将伦理贯穿时于设计、研究、开发、使用的每个环节,并且伦理的研究团队以及研发团队,同步保持跟政府、学术界、媒体、潜在用户和服务、提供商高度交流,把存在的伦理风险防患于未然,在每个人工智能的流程中的每个环节,将伦理治理嵌入到全流程和全生命周期中。

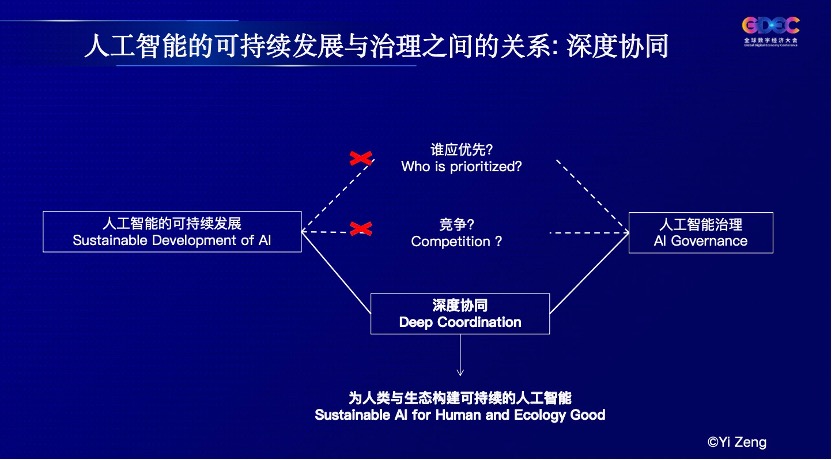

对于治理先行还是发展优先的问题,曾毅认为他们从来不是竞争关系,而是人工智能稳健发展两大前提,是深度协作的关系,缺一不可。也即通过人工智能的善治和可持续发展,真正实现为人类与生态创建可持续的人工智能。