图像生成一直是 AI 研究和应用的焦点。2014年,Ian Goodfellow 等人提出了 GAN,通过两个模型(生成模型和判别模型)的对抗来达到以假乱真的生成结果。在之后的几年里,GAN 逐渐成为图像生成领域的主流架构,也诞生了很多变体,比如著名的 StyleGAN。

2020年,基于神经辐射场(NeRF)的场景表征与容积渲染将图像生成带入3D时代,成为近两年来神经渲染方向的爆点工作之一,吸引了大量学者和商业巨头跟进。2021年,CVPR 最佳论文得主 GIRAFFE(Generative Neural Feature Fields)将 GAN 与 NeRF 结合,实现了可控的图像生成。前段时间,谷歌宣称用 NeRF 在虚拟世界中重建了旧金山市,用于自动驾驶。英伟达则宣称将训练 NeRF 模型的时间从 5 小时缩至 5 秒。

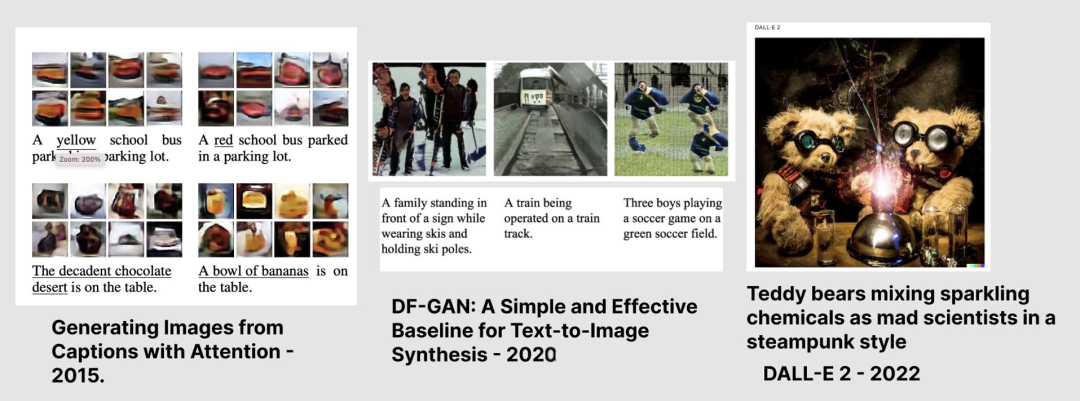

与此同时,OpenAI 提出的 DALL·E 又为图像生成创造了新的可能性,它可以根据文本生成图像,而且图像分辨率、图像-描述匹配程度和真实感都相当出色。最近,DALL·E 更新到了第二版(DALL·E 2),其生成能力令人叹为观止。

这些进展让我们看到了内容生成在现实生活中广泛应用的可能性。北京时间5月16日10:00—12:00,机器之心策划「后GAN时代的内容生成」线上圆桌,邀请到三位嘉宾结合自身近期工作,从不同角度分享图像及视频生成的基础研究与最新应用,并共同讨论 OpenAI 特别是 DALL·E 2 这项工作对既有图像生成技术的影响,同时展望未来逼真和创意图像生成。

特邀嘉宾与主题介绍

分享主题:基于GAN的古籍文档的修复

嘉宾简介:陈善雄,西南大学计算机与信息科学院教授,研究方向为模式识别、文档分析预处理。他是 CSIG 专业委员会委员,重庆市认知科学学会理事,中国通信学会移动媒体与文化计算委员会委员,目前在计算机学报、自动化学报、IEEE Computer Graphics and Applications、Applied Intelligence、IEEE Systems Journal 等国内外刊物上发表 SCI/EI 检索论文70余篇,国家发明专利20余项,科学出版社出版专著2部,在国际学术会议发表主题报告10余次

分享摘要:本次分享将分析利用生成对抗网络在古籍文档修复方面的一些工作,特别是在修复过程中字体风格的保持方面进行约束。

分享的工作部分来自论文「Dual Discriminator GAN: Restoring Ancient Yi Characters, ACM Transactions on Asian and Low-Resource Language Information Processing」(https://doi.org/10.1145/349003)

分享主题:便捷、高效、高保真数字人建模与驱动

嘉宾简介:张举勇2011年博士毕业于新加坡南洋理工大学,2011年至2012年于瑞士联邦理工学院洛桑分校从事博士后研究,2012年至今工作于中国科学技术大学任特任教授,获国家基金委优秀青年基金。研究兴趣为对真实物理世界中物体、场景与人的高效高保真三维数字化与生成。

分享摘要:对物理世界中物体、场景、人的高效高保真三维数字化一直以来都是计算机图形学、三维视觉、VR/AR等领域的核心研究问题。传统的建模与驱动方法依赖于昂贵的采集设备、复杂的制作流程、并需要专业人士的大量手工交互,这极大地限制了应用群体与应用范围。近年来,随着逆向渲染、神经隐式表示等技术的兴起,从拍摄的影像数据即可建模所拍摄对象的高精度几何模型,并在呈现真实度方面具有较大的优势。跟真实物理世界一样,数字人是未来人们进入虚拟数字世界的重要入口,而创建高保真超写实数字人是多种虚拟数字人类型中的圣杯。

相比于传统的光场相机来说,最新的数字人建模算法已可只需少数几个视角的视频作为输入。然而,对于普通用户来说,仍然难以采集同步的稀疏视角的视频数据,从而限制了这些算法的大范围应用。中科大3DV课题组在基于单目视频的高保真数字人建模与驱动方面开展了多方面的研究,包括基于单目视频的完整头部建模与说话数字人生成,穿衣人体建模与驱动,拟实现数字化每个人的愿景。

本报告涉及的相关论文如下:

Prior-Guided Multi-View 3D Head Reconstruction, Xueying Wang, Yudong Guo, Zhongqi Yang, Juyong Zhang, IEEE Transactions on Multimedia (TMM), 2021.论文链接:https://arxiv.org/abs/2107.04277

AD-NeRF: Audio Driven Neural Radiance Fields for Talking Head Synthesis, Yudong Guo, Keyu Chen, Sen Liang, Yong-Jin Liu, Hujun Bao, Juyong Zhang, IEEE/CVF International Conference on Computer Vision (ICCV), 2021.项目链接:https://yudongguo.github.io/ADNeRF/

HeadNeRF: A Real-time NeRF-based Parametric Head Model, Yang Hong, Bo Peng, Haiyao Xiao, Ligang Liu, Juyong Zhang, IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2022.项目链接:https://hy1995.top/HeadNeRF-Project/

SelfRecon: Self Reconstruction Your Digital Avatar from Monocular Video, Boyi Jiang, Yang Hong, Hujun Bao, Juyong Zhang, IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR, Oral Presentation), 2022.

项目链接:

https://jby1993.github.io/SelfRecon/

分享主题:图片生成模型的创造力和交互性

嘉宾简介:周博磊为加州大学洛杉矶分校(UCLA)助理教授,研究方向是计算机视觉和机器智能决策,博士毕业于麻省理工学院。周博士在模型可解释性和场景理解方向有突出贡献,开发了 CAM 和 Network Dissection 方法,以及 Places 和 ADE20K 数据库,有五篇引用量过千的一作论文。

分享摘要:周教授将分享他对生成模型的创造力的看法,以及他们课题组把生成模型用到交互内容创作中的一些尝试。分享的工作部分来自 OpenAI 的 DALL·E 2,部分来自他们 GenForce 研究项目(https://genforce.github.io/)。

加群看直播

直播间:关注机器之心机动组视频号,北京时间5月16日10:00开播。

交流群:本次直播有QA环节,欢迎加入本次直播交流群探讨交流。

机器之心 · 机动组

机动组是机器之心发起的人工智能技术社区,聚焦于学术研究与技术实践主题内容,为社区用户带来技术线上公开课、学术分享、技术实践、走近顶尖实验室等系列内容。机动组也将不定期举办线下学术交流会与组织人才服务、产业技术对接等活动,欢迎所有 AI 领域技术从业者加入。