在 Deepfake 的世界,真真假假,有时的确难以区分。

AI 算法「Deepfake」可以生成各种有关人物的逼真图像和视频,在换脸领域已经有了广泛的应用。不过,AI 换脸技术引发的争议不断,比如利用 Deepfake 制作成人视频等,给人们造成了极大困扰。

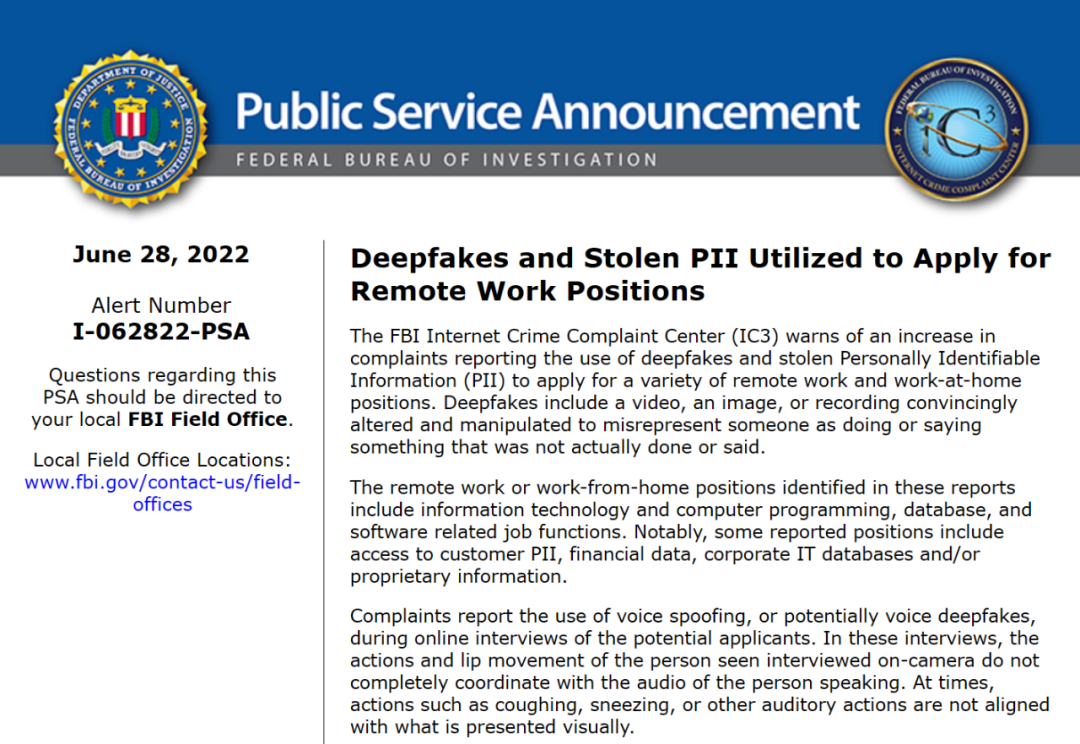

近日,根据外媒 pcmag 报道,FBI 表示有诈骗者一直使用 Deepfake 技术在远程工作的面试中冒充求职者,试图谋得 IT 公司的工作机会,以访问它们的客户或财务数据、企业 IT 数据库和 / 或专有信息。

有些公司透露,有些申请者的个人身份信息甚至属于另外一个人。

事情是这样的。在当地时间 6 月 28 日,FBI 网络犯罪投诉中心(IC3)在一次公共咨询中表示,最近有关被冒充求职的投诉案件数量增加。诈骗者一直利用 Deepfake 技术以及从受害者那里盗取的个人身份信息,骗过雇主雇佣他们进行远程或居家办公工作。

这些工作涉及到 IT 和计算机编程、数据库以及软件相关的职位。

图源:https://www.ic3.gov/Media/Y2022/PSA220628

图源:https://www.ic3.gov/Media/Y2022/PSA220628以往,Deepfake 使用 AI 赋能的程序来创建逼真但虚假的人物形象。在视频方面,该技术可以将名人的脸复刻到其他人的身上;在音频方面,该技术可以克隆一个人的声音,操纵它说出任何你想说的话。

然而此次,FBI 的咨询显示,Deepfake 技术也在助长身份盗用不法行径。在潜在申请者的在线面试中,诈骗者使用了语音欺骗或者声音伪造技术。诈骗者一直使用这些 Deepfake 技术申请 IT 公司的远程或居家办公职位。

虽然 FBI 没有说清楚这些诈骗者的最终目的是什么,但指出涉及到的职位包括访问客户 PII(个人身份信息)、财务数据、公司 IT 数据库和 / 或专有信息。这类信息可以帮助诈骗者从公司中窃取有价值的资料并实施其他身份欺诈计划。

图源:https://www.bangkokpost.com/

图源:https://www.bangkokpost.com/不过,好消息是,雇主有方法来检测 Deepfake。虽然诈骗者一直与潜在雇主进行视频面试,但 FBI 指出,当诈骗者说话时,基于 AI 的技术仍显示出缺陷。

比如,在镜头前面试者的动作和嘴唇运动与他们说话的声音并不完全协调。有时,咳嗽、打喷嚏或其他听觉行为与视觉呈现的内容不一致。

原文链接:

https://www.pcmag.com/news/fbi-scammers-are-interviewing-for-remote-jobs-using-deepfake-tech