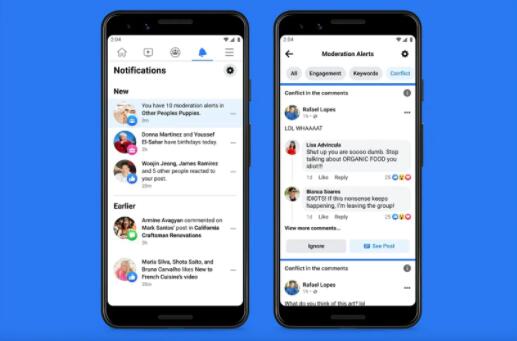

Facebook最近推出了一整套工具,可以帮助群组管理员更好地控制他们的社区。其中一些新工具提供了对帖子和成员的更清晰的概述,而另一些则旨在帮助管理员解决评论和他们所领导的社区中的冲突,例如人工智能驱动的功能,可以识别“有争议或不健康的对话”发生在注释。

这个特殊的工具叫做 Conflict Alerts,Facebook 目前正在测试这个。这基本上意味着不知道什么时候它会公开。这些冲突警报类似于现有的关键字警报功能,当评论者使用某些单词和短语时,管理员可以创建“自定义警报”。虽然这个过程不是手动的,但它使用机器学习模型来尝试发现更微妙的问题类型。

一旦组管理员收到警报,他们可以通过删除评论来采取行动,如果他们认为需要,他们也可以将用户引导出组。管理员还可以限制相关人员发表评论的频率,并控制对某些帖子发表评论的频率。

虽然从理论上讲,此冲突警报听起来不错,但不知道此功能将如何检测“有争议或不健康的对话”。当The Verge寻求评论时,Facebook 也没有澄清这一点。该发言人解释说,Facebook 将使用机器学习模型来查看“回复时间和评论量等多个信号,以确定用户之间的参与是否已经或可能导致负面互动”。

可以假设的是,Conflict Alerts 将使用类似于该平台已经用于标记网站上的辱骂性言论的 AI 系统。这些机器学习模型“远非 100% 可靠”,并且经常被讽刺、俚语和幽默等东西“愚弄”。尽管如此,人工智能系统应该能够获取更多“明显的线索”,表明正在发生争论——就像人们在评论中互相称对方为白痴一样,如上图所示。

作为该套件一部分的其他工具包括一个新的管理主页,它将用作仪表板并提供“帖子、成员和报告的评论”的概述。还可以访问新小组成员的摘要,这些摘要汇编“每个小组成员在小组中的活动,例如他们发布和评论的次数,或者他们在小组中删除帖子或被静音的时间”。此外,还有一项用于自动内容审核的新管理员协助功能,可让管理员通过禁止某些链接来限制允许发表评论的人、阻止最近加入的用户、遏制垃圾邮件和不需要的促销活动。冲突警报功能将成为此管理协助的一部分。您可以在此处阅读有关新工具的更多信息。