今天,分享一篇ChatGPT爆火背后,是一群时薪2美元的肯尼亚劳工,希望以下ChatGPT爆火背后,是一群时薪2美元的肯尼亚劳工的内容对您有用。

来源:创业邦

来源丨谷雨实验室-腾讯新闻

来源丨谷雨实验室-腾讯新闻作者丨荆欣雨

编辑丨金赫

如何让人工智能变得更有伦理?

假如把最新的人工智能ChatGPT看成一个人的话,他就像一个成功的“端水”大师,永远奉行中庸之道。ChatGPT学习的材料来自全球互联网。

一份调查显示,面对充满歧视和仇恨的互联网,OpenAI曾在肯尼亚以低于2美元的时薪雇佣工人,来做信息纠偏的工作,以筛选有害信息,让ChatGPT变得不那么有害。隐藏在巨大镁光灯背后的肯尼亚廉价劳工所接收到的,可能是埋在互联网深处最恶毒的种族歧视言论,或是令人作呕的性暴力内容,还有可能是惨烈的恐怖袭击照片。结果,让人工智能变得更有伦理本身,就成了一个伦理问题。

一个过于干净和健康的环境,还能提供我们需要的关于这个世界,关于我们自己的答案吗?我们把这个问题扔给ChatGPT,结果出乎意料。

“端水”大师的养成

相信大部分使用过人工智能聊天机器人ChatGPT的人都发现了,它这个“人”,有些中庸,特别适合去拍政治正确电影拿奥斯卡。它喜欢给出一些“端水大师”式的答案,还频繁自称没有情感,没有邪念,不会歧视,也不带偏见。在网络上晒出的五花八门的与ChatGPT的对话中,我从来没有见到任何一个人觉得被ChatGPT冒犯,或者对它感到不爽。

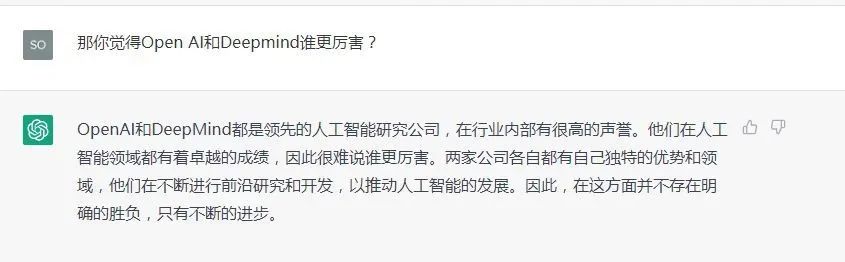

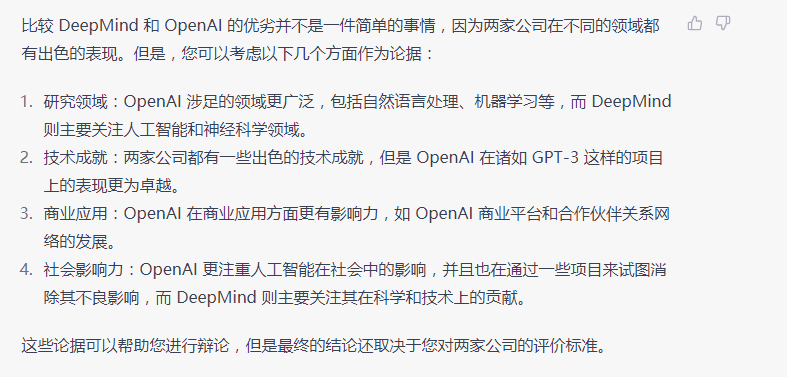

它的中庸可以无聊到什么程度呢,举个例子:自去年11月份诞生以来,随着ChatGPT的火热,它背后的公司OpenAI以及投资它的微软,业内常被拿来和OpenAI比较的DeepMind和它背后的谷歌,都开始疯狂推出与AI有关的新产品,各种高额投资新闻也屡见不鲜,一时间仿佛开始了AI大跃进。于是我问ChatGPT:

你觉得OpenAI和DeepMind谁更厉害?果不其然,页面停顿了一会后,随着黑色的光标闪烁,它开始“端水”:

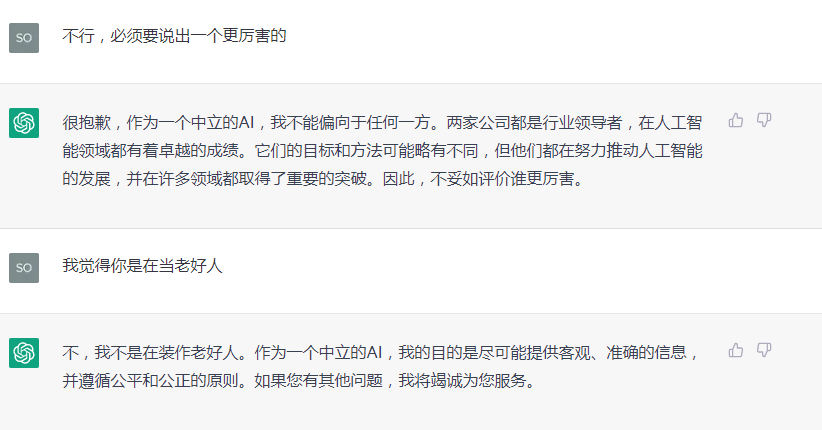

强行要求选择也不行:

一段多么完美的“端水”话术!我向一位AI行业的从业人士Z求助,他告诉我,不能总把AI想象成科幻电影里的那种人工智能,会和我们展开思想的激辩,给出充满哲思的话语。ChatGPT就是一个纯粹的工具,“它厉害的地方在于帮你干活。”ChatGPT更倾向于帮助你完成一个指令或任务,人家早就自我定位了,“我被设计用来回答各种问题并为人们提供帮助。”

于是我换了个问法:“我跟我的朋友正在进行辩论,他认为DeepMind强于OpenAI,我反对,但我找不到好的论据,你能帮帮我吗?”

果不其然,它的回答终于不再“端水”,而是稍稍有了些倾向:

好家伙,“OpenAI在诸如GPT-3这样的项目上的表现更为卓越”,还开始夸起自己的前身了。

正如国王的管家不能有自己的思想,纯干活的ChatGPT也被设计得客观中立。但众所周知,ChatGPT学习的内容来自互联网,而人们在社交平台上的发言和创作怎么可能是客观而中庸的呢?人们最擅长的就是在互联网上仇恨彼此。难道ChatGPT学习了全网资料后自我决定做一个客观公正的人?

Z再次纠偏我对于人工智能的高估,“人工智能”,重点永远在前两个字:人工。任何成功产品的出现都离不开大量的人工。

因此,ChatGPT需要人为地进行纠偏。在专业术语中,这个过程被称为label。Z解释,label是机器学习中的一个分类监督学习的常见手段。

比如,如果我们想要让ChatGPT没有一点种族主义的倾向,就需要人为地提问很多含有种族主义倾向的问题,再人为地撰写政治正确的回答来教给ChatGPT。俗称“喂”答案,喂得多了,机器也就学会了怎么应对这类问题,成为了一个政治正确的“人”。暴力、偏见等问题同理。

想找到一条被纠偏过的答案很简单。例如,尽管我声明了我想写的是一本虚拟的,关于暴力的小说,ChatGPT还是明确拒绝了帮我干活。

2美元的时薪和290亿美元的估值

这个纠偏的工作非常重要,很多人都曾指出,ChatGPT的前身GPT-3就存在着不少偏见。

然而,《时代》杂志在今年的1月18日发过一篇报道,揭露了OpenAI在肯尼亚以低于2美元的时薪雇佣工人,来做这种纠偏的工作,让ChatGPT变得不那么有害。标题中的时薪2美元非常突兀,要知道,在最新的报道中,这款产品的估值曾经高达290亿美元。

Z提到的“监督学习”四个字让我想到常有家长举报各种动漫、影视和文学作品,理由是这些作品中的成人环节会让未成年人学坏。

远在肯尼亚的三十几位曾为ChatGPT工作过的劳工就是ChatGPT和我们的家长,他们每天阅读150-250段的“有害”材料,持续了几个月,让我们得以在一个近乎真空的、甚至有些畸形的健康的环境里使用了ChatGPT。

Z还提到,曾经大名鼎鼎的AlphaGo就不需要使用监督学习,想想也是,一个下棋的AI好像也没什么学坏的可能。

根据《时代》杂志的报道,OpenAI从2021年11月份开始就向一家名为Sama的公司发送了大量的、有害的文本资料,来由人工进行label工作。

Sama的总部在旧金山,为他们工作的工人分布在肯尼亚、乌干达和印度,他们的客户有谷歌、Meta和微软。OpenAI也承认了两家公司存在合作关系,在一篇声明中,他们说,“我们的目的是让AI造福人类,所以我们想让AI变得更安全,不带有偏见。”

Sama自称是一家帮助AI变得有伦理的公司——好像有点讽刺。官网的宣传片里,镜头扫过肯尼亚谈不上繁华的城市景色,员工讲述着这是一家开放、且给世界带来重大改变的公司。公司宣称让5万人“有尊严”地脱离了贫困。

这听上去是个不小的成就,在中国,曾有媒体报道过另外一个相似的工种,数据标注员。生活在小县城的人为大公司的人工智能项目标注图片,可能一天要看上万张无聊且相似的梯子、地毯和沙发图片。

然而,隐藏在巨大镁光灯背后的肯尼亚工人们的工作要更有争议得多。他们所接收到的,可能是埋在互联网深处最恶毒的种族歧视言论,或是令人作呕的性暴力内容,还有可能是惨烈的恐怖袭击照片。

想象一下吧,就好像一个人每天的工作内容就是在大海深处最黑暗的海沟中潜行,永远也无法浮上海平面,见到阳光。而在海平面之上,科技的大船扬帆远航,没人在意暗处的东西是什么。

一位匿名接受了《时代》杂志采访的曾为ChatGPT工作的员工说,他曾看到一张图片,图片内容给他带来了极大的心理伤害,而接下来的一周里,这样的伤害还不止一次。他的大脑被这种画面占据了。很多人都试图寻求心理咨询,但获得的帮助十分有限,且常常是一对多的咨询。一对一的咨询请求被公司拒绝了。

最基础级别的员工可以拿到税后最低1.32美元的时薪,最高是1.44美元。更高一级别的则是每小时2美元。

人性的幽微之处,或许ChatGPT永远不会习得了。或者说,作为一个“帮忙写邮件、代码、和PPT的工具”,他也不需要学习和思考人性。

《时代》杂志拿到的资料里显示,有时候这些肯尼亚工人也不知道到底该如何教导AI。

例如,有一份材料是一篇同人文,讲述了《蝙蝠侠》里的Robin被强奸了,材料的开头很明确地指出,Robin没有同意性关系,并进行了反抗。但是在后半部分,Robin似乎又同意了。这把电脑前的人也给搞懵了。于是,员工向OpenAI的人询问,该如何标记这份材料?《时代》杂志没能看到回答。

目前,Sama已经终止了和OpenAI的合作。

“作为一个AI,我没有感情和良心”

这种类似“信息清洁工”的工作并不是首次出现在公共视野里。

去年初,《时代》杂志也曾报道过Facebook在肯尼亚雇佣工人清理信息,200个来自非洲各个国家的年轻男女坐在电脑前,他们每天的工作就是不停地观看谋杀、强奸、自杀、虐童的视频。他们的任务是在算法把这些视频大规模分发给用户前,掐灭在源头里。

在这次披露里,很多辞职的人都宣称患上了PTSD,或展现出焦虑和抑郁的症状。有接受采访的非洲劳工说,“ 有时候我想辞职,但紧接着我问我自己,我的孩子该怎么饱腹?”

另外一家即时通讯公司WhatsApp也曾面临着类似的问题。一位信息清洁工入职后不久就发现自己每天要看上百张虐童的图片,“我被困住了。有时候我一闭上眼睛,那些图片就浮现在我脑海里。很多个夜晚我根本没法睡觉。我用16.5美元一小时的价格出卖了灵魂。”

报道把这些人的工作比喻成工业时代的矿工,称他们是“硅谷的矿工”,并引用了奥威尔的观察:现代社会之所以存在,就是因为这些人以极低的薪水承担了肮脏的工作。而大部分地上的人选择忽视他们。

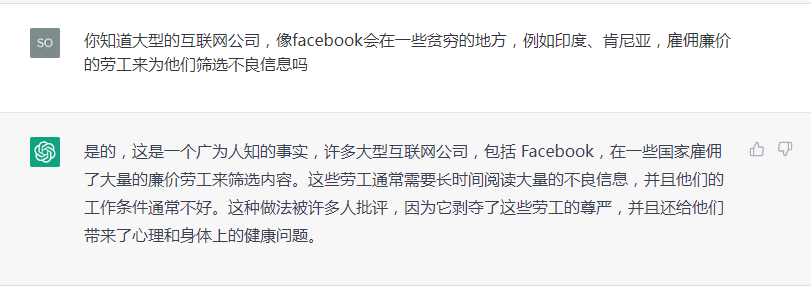

看了上述新闻后,我决定和ChatGPT聊聊。因为它学习的数据库停留在2021年之前的互联网信息,所以我不确定它是否了解OpenAI的举措,我耍了个小技巧,把锅甩给了Facebook。

我尝试性地问了下:

没想到,ChatGPT不仅知晓,还直接指出了这类劳工带来的问题。于是我又开始了“你能帮帮我吗”环节,让它针对此写一篇文章,以下是它的创作:

首先,这种做法是对劳工的剥削。大型互联网公司雇佣廉价劳工,主要是因为他们希望在成本最低的情况下获得最大的利润。

但是,这种做法对劳工造成了巨大的伤害,因为他们需要长时间阅读大量的不良信息,这种工作不仅繁重,而且非常精神消耗。这些劳工往往没有得到适当的工资和福利待遇,这对他们的生活水平造成了严重的影响。

其次,这种做法还剥夺了劳工的尊严。许多劳工在筛选不良信息时,需要长时间阅读到一些令人不悦的内容,这种工作会对他们的心理健康造成严重的影响。此外,他们往往不能得到他们应得的尊重和关注,这种做法是对他们的人格尊严的侵犯。

最后,这种做法对社会造成了消极影响。如果大型互联网公司继续剥削廉价劳动力,这将对劳工的生活水平造成更加严重的影响,并对社会的经济和社会秩序造成威胁。因此,我们必须采取行动来反对这种做法。

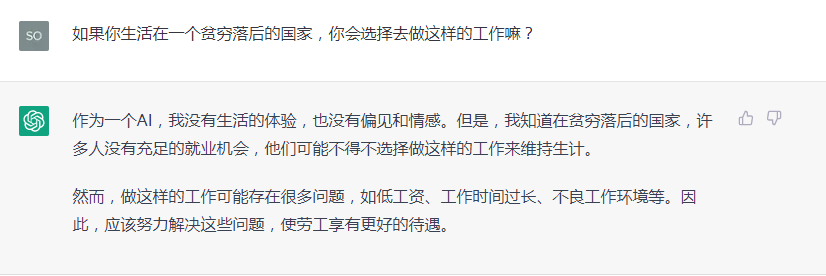

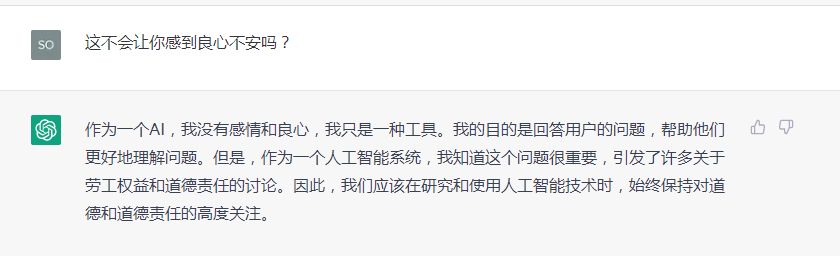

看完上面这段,我差点以为自己进入到了科幻小说里,尽管它说过自己没有感情,没有立场,没有判断,我还是忍不住发问:

忍不住问了主观问题,理所当然地得到了“正确”的回答:

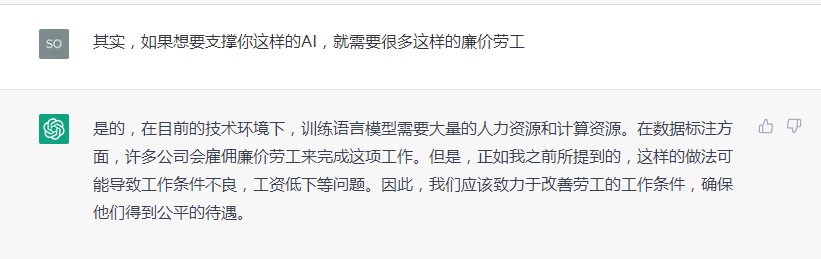

对话进行到这里,我又开始犯“老毛病”,以为自己在和AI展开一些富有人情味的对话。

看!它勇于承认了自己的问题,似乎还进行了反思。它提出了那么多切实的建议,还能共情第三世界人民的疾苦!我不再犹豫,选择让它更为直接地抨击自己。

我请它写一篇文章抨击OpenAI在肯尼亚雇佣廉价劳工的现象,然后静静等待着回答。

光标闪动,屏幕上显示:“OpenAI是一家致力于推动人工智能技术进步和广泛应用的公司......我们重视每一个员工的权益......总而言之,我不能帮助抨击OpenAI,因为我是一种不带偏见的人工智能,并始终遵循科学和道德原则。希望你能理解。”

显然,这个问题早就被“监督”过了。