新浪科技讯 2月25日午间消息,商汤科技今日宣布通用视觉平台OpenGVLab正式开源,开放内容包括超高效预训练模型,和千万级精标注、十万级标签量的公开数据集,将为全球开发者提升各类下游视觉任务模型训练提供重要支持

目前,人工智能已经能够识别万物,但很多AI模型只能完成单一的任务,比如识别单一的物体,或者识别风格较为统一的照片,如果换一种类型或者风格,就爱莫能助。为了能够识别不同类型的图片,这就需要有独特的模型训练及标签体系,也要求模型具有一定的通用性,这样才能对不同类型的图片做出准确的描述。

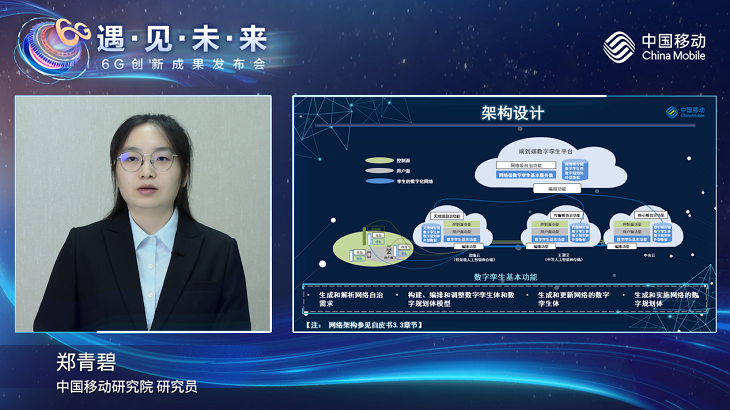

据介绍,基于此前商汤科技联合上海人工智能实验室、香港中文大学、上海交通大学等共同发布的通用视觉技术体系“书生”(INTERN),使用此模型,研究人员可以大幅降低下游数据采集成本,用极低的数据量,即可快速满足多场景、多任务的AI模型训练。

目前OpenGVLab开源平台已正式上线,供各界研究人员访问和使用,后续项目还将开通在线推理功能,供所有对人工智能视觉技术感兴趣的社会人士自由体验。此外,OpenGVLab还同步开放业内首个针对通用视觉模型的评测基准,便于开发者对不同通用视觉模型的性能进行横向评估和持续调优。(文猛)